深言科技创始人兼CEO岂凡超

深言科技,孵化自清华大学自然语言处理实验室(THUNLP)和北京智源人工智能研究院(BAAI)。早在2021年1月,创始团队参与完成智源悟道CPM大模型训练,并在同年12月率先运用了可控预训练技术进行CPM-3模型训练。2022年3月,深言科技正式成立,旨在打造基于大规模预训练模型的新一代智能文本信息处理平台。在深言科技的模型训练与部署过程中,阿里云PAI平台为其提供了低成本、高性能、灵活便捷的产品服务体验。

大模型是最近半年最火热的创业赛道,要做好这件事,我们一直坚持着四个底层逻辑:

首先是要在高原上构建高峰。高原指的是基础模型能力,而高峰指的是解决特定任务、特定领域问题的能力。

与过去的自然语言处理不同,今天的基础模型在整体能力上有了非常大的提升。如果想要进入大模型赛道,必须要有一个比较强的基础模型,不管是基于别人的模型还是自研模型。但只有基础模型还不够,在基础模型之上的垂直能力建设才是创业企业的差异化优势高峰。

我们从必要性和可行性来看,无论模型的规模和参数量有多大,始终会存在知识冲突和行业数据之间的矛盾。例如在教育场景下,模型在语文、数学、代码等不同领域的能力是此消彼长的,即使通过收集大量的语文、数学和编程数据来训练模型,这些数据也可能存在冲突和互相影响的情况。另一方面是成本的问题,因为如果想要整体上提升大模型的能力,对参数量、算力的要求会非常高。

在这种情况下,如果要务实地推动模型落地,则需要基于现有的基础模型,通过垂直能力或解决特定领域问题的能力来实现。我们可以看到,gpt-3.5-turbo模型开放了微调接口,经过微调后,效果比GPT4更好,这也证明了可以通过垂直化和微调技术来提高模型性能的可行性。

其次是大模型创业要走好最后一公里。现在很多模型采用简单统一的对话交互模式,集成了多项能力,似乎能够应对所有的问题。但在真正落地的过程中,我们就会发现,不仅是交互,就连模型本身也存在突出的局限性,比如幻觉问题、逻辑推理问题、运算、知识更新问题等,这些都是现有大模型难以解决的难题。大模型距离最后的业务场景落地还有一些路要走,不管是对模型进行改造,还是在工程上进行优化,或是配合其它工具使用,这些都是必要的。

再者是场景驱动,数据闭环。从模型到产品落地,甚至最后做出差异化和商业化,这些都需要场景驱动,并在最终达成数据的闭环。因为无论大模型技术再怎么强大,最终还是要遵循技术逻辑和商业逻辑。在模型落地的过程中,有几个关于数据的问题需要重点考虑:

第一,如何对数据进行分类分析。模型训练的数据可能涉及不同任务、不同行业、不同领域;此外还有不同颗粒度的数据,比如个人数据、组织数据等。

第二,怎么对数据进行选择和过滤。我们发现低质量的数据可能会影响模型的训练效果,甚至导致模型无法达到预期效果。所以需要考虑如何准确筛选出符合任务需求的数据,并通过先进的技术手段对其进行处理和过滤,从而使其适用于模型训练。

第三,选择在哪个环节加入数据。数据贯穿了模型的预训练、持续训练、标注、对齐等环节。每个环节的数据参与度都不同,对最终结果的影响也不尽相同。因此,选择何时加入什么数据是一个需要仔细思考的问题,因为每个环节都有其独特的优缺点。

第四,如何让数据达成闭环。这既需要产品的思考,同时也需要模型和技术的支持。比如,当收集到一些用户的个性化数据,如何发挥数据的最大价值,使其数据飞轮转起并构建壁垒,这些都是需要我们去思考的。

最后,要想做好大模型并实现落地,对模型在预训练、持续训练、微调、对齐等环节进行全链路的优化至关重要。链路越深,数据发挥的杠杆作用越大,优化空间也会越大,所构建的技术壁垒也会越高。

回到2021年初,当我们开始着手构建大模型时,国内大模型的发展仍处于早期阶段,很多人甚至没有具体的概念。但最本质、最核心的商业问题是,大模型需要针对哪些特定人群、解决什么问题、并创造出什么价值。

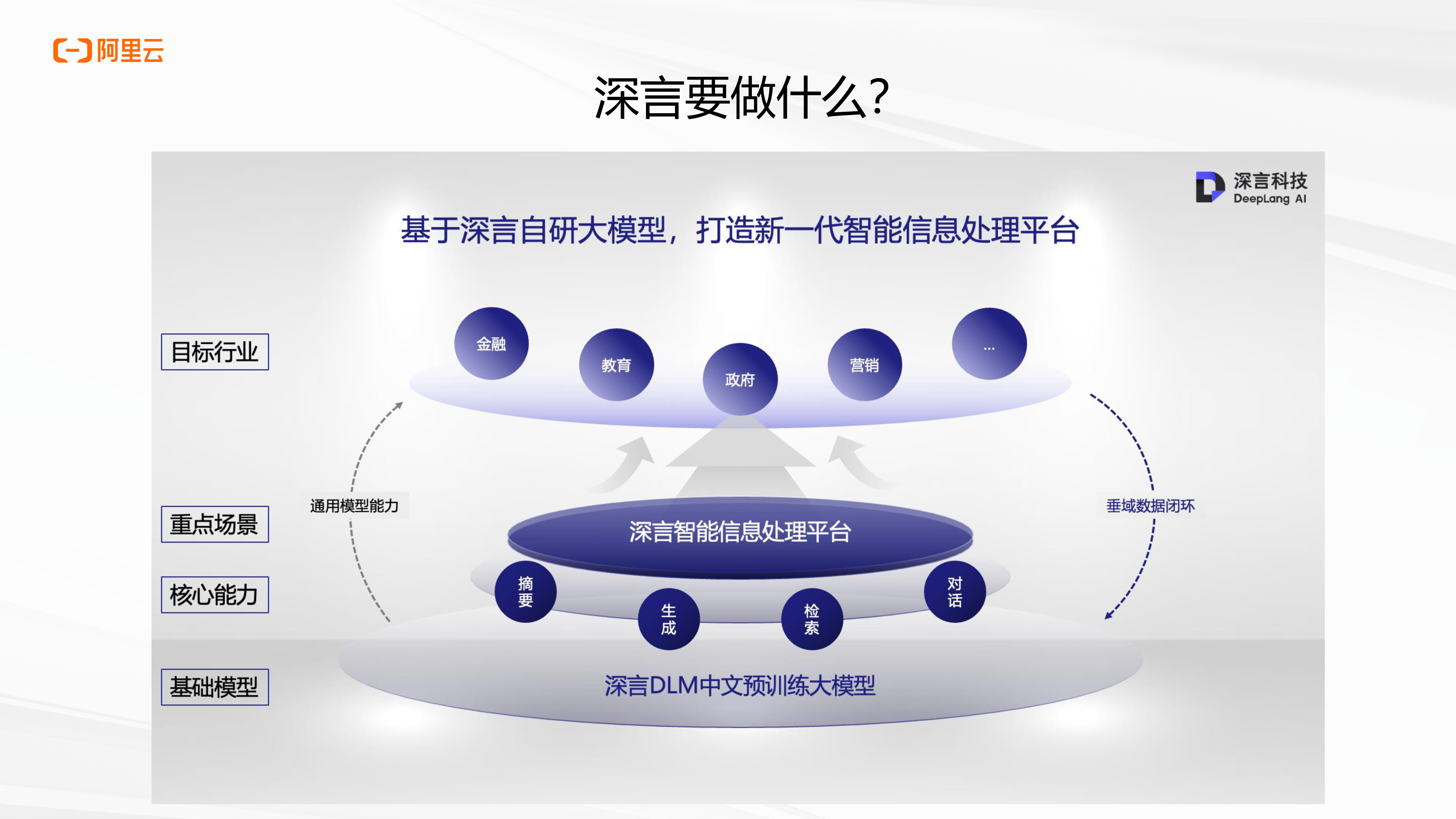

我们可以分四个层次去看大模型的落地和商业化。最底层是模型,包括通用模型和垂直领域、任务专用模型。往上是能力,用于解决再上一层的重点场景和特定任务。最上面是基于重点场景的目标行业泛化。当中最核心的中间环节是场景,链接了供需两侧。

我们调研了很多行业,包括政府、金融、媒体、营销、教育等,发现他们都存在很多信息处理的需求,最后提炼归纳出一个信息处理的闭环场景。可拆分为三个环节:信息输入、信息处理和信息输出。原始信息从不同的渠道进入个人或组织的信息处理中枢,经过加工和整合后产生新的信息,同时这些信息也被存储在组织的信息仓库中,以便后续使用。

当下,每个环节都可以依靠大模型来重塑,市面上也有各个环节相应的产品,但还没有一个模型能够真正达成闭环。要想每个环节想要做好,光靠大模型是不够的,即便是连GPT-4或Claude-2这样当前最先进的通用大模型也难以完美解决。相反,对模型结合场景或任务数据进行微调,或者加上其他能力的模型作为辅助,最终效果反而超过通用大模型。

创业第一年,深言科技致力于使用可控的预训练技术来训练模型,使其具有可控生成的能力。今年,我们也在不断创新和探索,借助最新的技术,针对一些大模型落地所需解决的问题,如长文本的处理、数据间的匹配等问题进行了深入探索。如同构建高原上的高峰,深言科技针对不同行业或领域,通过大模型解决特定场景下所需的任务,包括检索、生成、对话、摘要等。

以我们的产品深言达意为例,结合了大语言模型和检索能力,使用自然语言对话交互,能够寻找用户想要的词语或句子。比如,如果用户想说今天天气很热,它可以找到表达这个意思的词语或句子,例如“火伞高张”、“皎阳似火”等;此外,用户还可以使用更复杂的描述来搜索,比如“热”字的相关词汇。今天,我们的产品已经拥有超过800万用户和70万月活跃用户。

这个产品本身也满足上述四个底层逻辑。首先是构建高原与高峰。我们在自研大模型的基础上,针对词句检索的任务需求,使用大量相关语料进行模型微调训练,其中还包括很多标注的工作,实现适合于此任务的垂直模型。

第二是走好最后一公里。光靠大语言模型驱动可以做自然语言的交互,但因为幻觉问题、知识的问题,很多生成内容无法直接使用。所以大模型理解完需求后,还要靠语言检索的能力去实现更准确的所需词语或句子检索 —— 这是当前只依靠chatGPT等生成模型无法做到的。

第三是搭建数据闭环。深言达意会持续收集用户的反馈数据和查询数据,并迭代模型。我们到现在已经收集了近百万条用户数据,不断地提升了模型的能力。

最后是全链路的优化,预训练阶段自己的模型会加很多相关数据做预训练,包括后面的SFT和对齐,都针对任务去做优化。最终实现了针对大模型在这一场景的深度定制和融合。

创业至今,阿里云帮助了我们很多,最核心的还是提供强大的GPU算力。深言科技主要基于阿里云PAI平台进行大模型训练和部署,包括在机器学习和框架层搭建、交互式建模的能力。我们最大的感受是体验好、低成本、高性能。

我们利用PAI-DSW和PAI-DLC,可以灵活地进行交互式编程,使用各种灵活稳定的训练环境,减轻模型训练的工程成本,工作效率非常高。

我们曾经考虑过是否要自建机房,经过调研后发现对于我们这样体量的企业来说成本太高,尤其是运维成本。PAI平台可以很方便地与其他云产品,如OSS等进行连接,有效降低模型整体的训练成本和运营管理成本。

最后在性能训练上,除了硬件环境,阿里云还提供了很多中间的模块和组件,能够帮助我们提高模型性能。我们可以利用EasyCkpt组件,能够快速存储模型,降低因训练中断带来的损耗。

我们已在阿里云PAI平台的近千卡集群上稳定训练约1个月,GPU计算使用率接近100%,FLOPs利用率超过50%。这是我们现在在阿里云灵骏平台上做的部署。除此之外,我们也在借助阿里云的弹性计算等产品对外提供服务。

阿里云创业者计划,点击了解更多:

https://startup.aliyun.com/startups

你好,我是AI助理

可以解答问题、推荐解决方案等